hbase 简介

概述

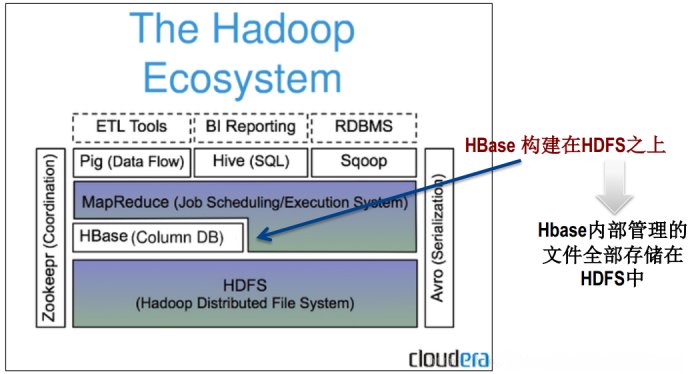

hbase是一个构建在hdfs上的分布式列存储系统;

hbase是基于googlebigtable模型开发的,典型的key/value系统;

hbase是apachehadoop生态系统中的重要一员,主要用于海量结构化数据存储;

从逻辑上讲,hbase将数据按照表、行和列进行存储。

与hadoop一样,hbase目标主要依靠横向扩展,通过不断增加廉价的商用服务器,来增加计算和存储能力。

hbase表的特点

大:一个表可以有数十亿行,上百万列;

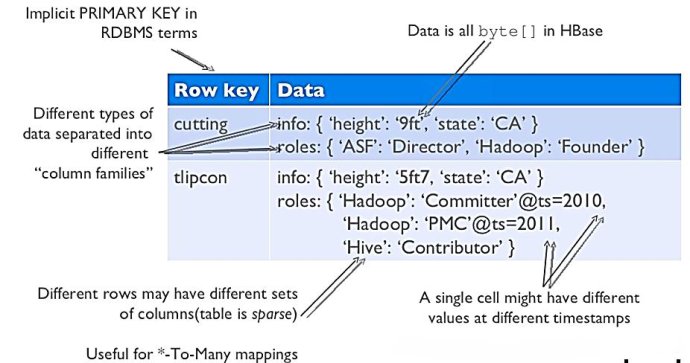

无模式:每行都有一个可排序的主键和任意多的列,列可以根据需要动态的增加,同一张表中不同的行可以有截然不同的列;

面向列:面向列(族)的存储和权限控制,列(族)独立检索;

稀疏:空(null)列并不占用存储空间,表可以设计的非常稀疏;

数据多版本:每个单元中的数据可以有多个版本,默认情况下版本号自动分配,是单元格插入时的时间戳;

数据类型单一:hbase中的数据都是字符串,没有类型。

·hbase数据模型

hbase逻辑视图

注意上图中的英文说明

hbase基本概念

rowkey:是bytearray,是表中每条记录的“主键”,方便快速查找,rowkey的设计非常重要。

columnfamily:列族,拥有一个名称(string),包含一个或者多个相关列

column:属于某一个columnfamily,familyname:columnname,每条记录可动态添加

versionnumber:类型为long,默认值是系统时间戳,可由用户自定义

value(cell):bytearray

·hbase物理模型

每个columnfamily存储在hdfs上的一个单独文件中,空值不会被保存。

key和 version number在每个 column family中均有一份;

hbase为每个值维护了多级索引,即:

物理存储:

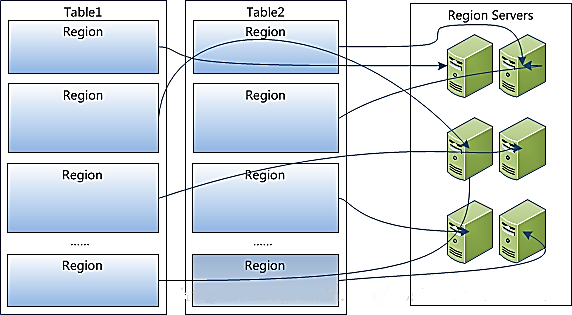

1、table中所有行都按照rowkey的字典序排列;

2、table在行的方向上分割为多个region;

3、region按大小分割的,每个表开始只有一个region,随着数据增多,region不断增大,当增大到一个阀值的时候,region就会等分会两个新的region,之后会有越来越多的region;

4、region是hbase中分布式存储和负载均衡的最小单元,不同region分布到不同regionserver上。

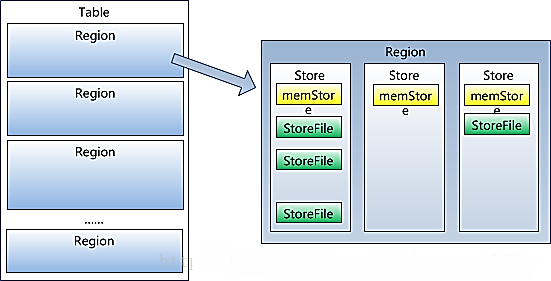

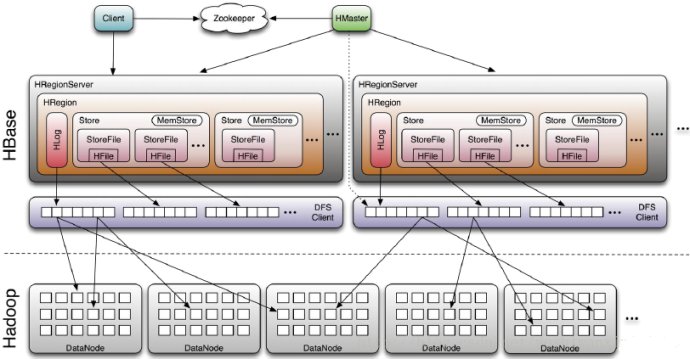

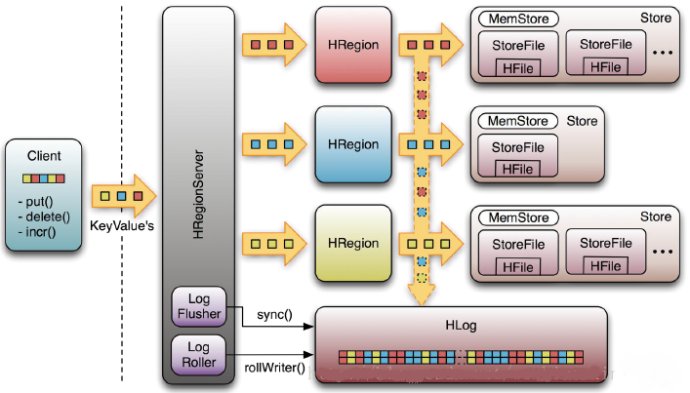

5、region虽然是分布式存储的最小单元,但并不是存储的最小单元。region由一个或者多个store组成,每个store保存一个columnsfamily;每个strore又由一个memstore和0至多个storefile组成,storefile包含hfile;memstore存储在内存中,storefile存储在hdfs上。

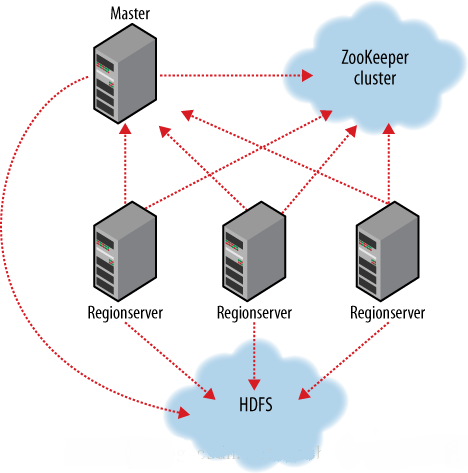

·hbase架构及基本组件

hbase基本组件说明:

client

ü包含访问hbase的接口,并维护cache来加快对hbase的访问,比如region的位置信息

master

ü为regionserver分配region

ü负责regionserver的负载均衡

ü发现失效的regionserver并重新分配其上的region

ü管理用户对table的增删改查操作

regionserver

üregionserver维护region,处理对这些region的io请求

üregionserver负责切分在运行过程中变得过大的region

zookeeper作用

ü通过选举,保证任何时候,集群中只有一个master,master与regionservers启动时会向zookeeper注册

ü存贮所有region的寻址入口

ü实时监控regionserver的上线和下线信息。并实时通知给master

ü存储hbase的schema和table元数据

ü默认情况下,hbase管理zookeeper 实例,比如, 启动或者停止zookeeper

üzookeeper的引入使得master不再是单点故障

write-ahead-log(wal)

该机制用于数据的容错和恢复:

每个hregionserver中都有一个hlog对象,hlog是一个实现writeaheadlog的类,在每次用户操作写入memstore的同时,也会写一份数据到hlog文件中(hlog文件格式见后续),hlog文件定期会滚动出新的,并删除旧的文件(已持久化到storefile中的数据)。当hregionserver意外终止后,hmaster会通过zookeeper感知到,hmaster首先会处理遗留的hlog文件,将其中不同region的log数据进行拆分,分别放到相应region的目录下,然后再将失效的region重新分配,领取到这些region的hregionserver在load region的过程中,会发现有历史hlog需要处理,因此会replayhlog中的数据到memstore中,然后flush到storefiles,完成数据恢复

hbase容错性

master容错:zookeeper重新选择一个新的master

ü无master过程中,数据读取仍照常进行;

ü无master过程中,region切分、负载均衡等无法进行;

regionserver容错:定时向zookeeper汇报心跳,如果一旦时间内未出现心跳,master将该regionserver上的region重新分配

到其他regionserver上,失效服务器上“预写”日志由主服务器进行分割并派送给新的regionserver

zookeeper容错:zookeeper是一个可靠地服务,一般配置3或5个zookeeper实例

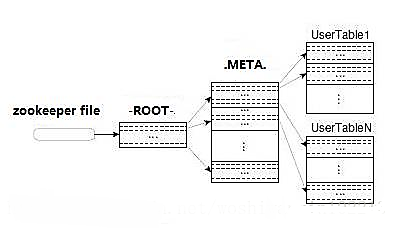

region定位流程:

寻找regionserver

zookeeper-->-root-(单region)-->.meta.-->用户表

-root-

ü表包含.meta.表所在的region列表,该表只会有一个region;

üzookeeper中记录了-root-表的location。

.meta.

ü表包含所有的用户空间region列表,以及regionserver的服务器地址。

·hbase使用场景

|

1

2

3

4

5

6

|

storing large amounts of data(100s oftbs)

needhigh write throughput

needefficient random access(key lookups) within large datasets

needto scale gracefully with data

forstructured and semi-structured data

don'tneed fullrdms capabilities(cross row/cross table transaction,joins,etc.)

|

大数据量存储,大数据量高并发操作

需要对数据随机读写操作

读写访问均是非常简单的操作

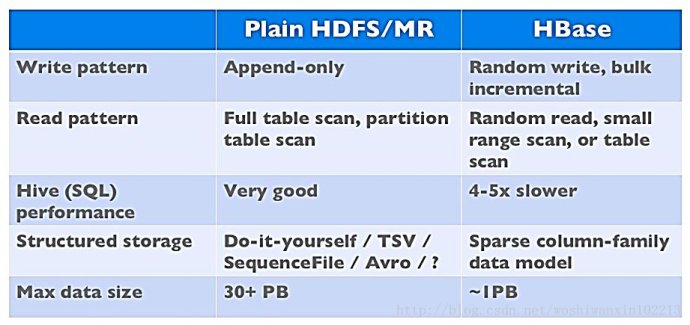

·hbase与hdfs对比

两者都具有良好的容错性和扩展性,都可以扩展到成百上千个节点;

hdfs适合批处理场景

不支持数据随机查找

不适合增量数据处理

不支持数据更新

原文链接:http://blog.sina.com.cn/s/blog_9c6852670102wx06.html

本文由主机测评网发布,不代表主机测评网立场,转载联系作者并注明出处:https://zhuji.jb51.net/linux/5426.html