Linux中Centos7搭建Hadoop服务步骤

下载Hadoop 官网:http://hadoop.apache.org/releases.html

先配置jdk环境

下载以后 解压到到/usr/local

1 | tar -zxvf hadoop-2.8.0.tar.gz -c /usr/local |

为了方便操作 把hadoop-2.8.0 改为hadoop

1 | mv /usr/local/hadoop-2.8.0 /usr/local/hadoop |

查看主机名

1 | hostname //第一个参数为主机名 |

检查是否可以免密码

1 | ssh localhost //这里的localhost为主机名 |

注意:一般初次安装都需要密码

1 | ssh-keygen -t dsa -p '' -f ~/.ssh/id_dsa |

1 | cat ~/.ssh/id_dsa.pub >> ~/.ssh/authorized_keys |

再次验证

1 | ssh-keygen -t dsa -p '' -f ~/.ssh/id_dsa |

1 | cat ~/.ssh/id_dsa.pub >> ~/.ssh/authorized_keys |

注意:如没有enter password 就说明免密码了

配置环境变量

1 | vim /etc/profile |

末尾添加

1

2 | export hadoop_home=/usr/local/hadoop export path=$java_home/bin:$path:$home/bin:$hadoop_home/bin |

使环境变量立即生效

1 | source /etc/profile |

创建hadoop的临时文件存放地

1 | mkdir /usr/local/hadoop/tmp |

编辑hadoop的配置文件

1

2 | cd /usr/local/hadoop/etc/hadoop/vim hadoop-env.sh |

末尾添加

1

2 | export java_home=/usr/local/java/jdk1.8.0_131/ export hadoop_conf_dir=/usr/local/hadoop/etc/hadoop |

注意:路径要对

使环境变量立即生效

1 | source hadoop-env.sh |

配置另一个文件

1 | vim core-site.xml |

在

1

2

3

4

5

6

7

8 | <property> <name>fs.defaultfs <value>hdfs://localhost:9000 <property> <name>hadoop.tmp.dir<value>file:/usr/local/hadoop/tmp |

配置下一个文件 hdfs-site.xml

1 | vim hdfs-site.xml |

在

1

2

3

4

5

6

7

8

9

10

11

12 | <property> <name>dfs.replication <value>1 <property> <name>dfs.namenode.name.dir <value>file:/usr/local/hadoop/tmp/dfs/name <property> <name>dfs.datanode.data.dir <value>file:/usr/local/hadoop/tmp/dfs/data |

配置下一个文件mapred-site.xml 因为这个文件默认不存在 我们把mapred-site.xml.template作为模板来配置

1 | cp mapred-site.xml.template mapred-site.xml |

vim mapred-site.xml

在

1

2

3

4 | <property> <name>mapreduce.framework.name <value>yarn |

配置下下个文件yarn-site.xml

1 | vim yarn-site.xml |

在

1

2

3

4 | <property> <name>yarn.nodemanager.aux-services <value>mapreduce_shuffle |

配置最后一个文件yarn-env.sh

vim yarn-env.sh

注意:在第23行左右 export java_home (删除# 去掉注释),并更改正确jdk的路径

格式化namenode

1

2 | cd /usr/local/hadoopbin/hdfs namenode-format |

注意:成功的话,会看到 “successfully formatted” 和 “exitting withstatus 0” 的提示,若为 “exitting with status 1” 则是出错了

通过脚本启动hdfs

1 | sbin/start-dfs.sh |

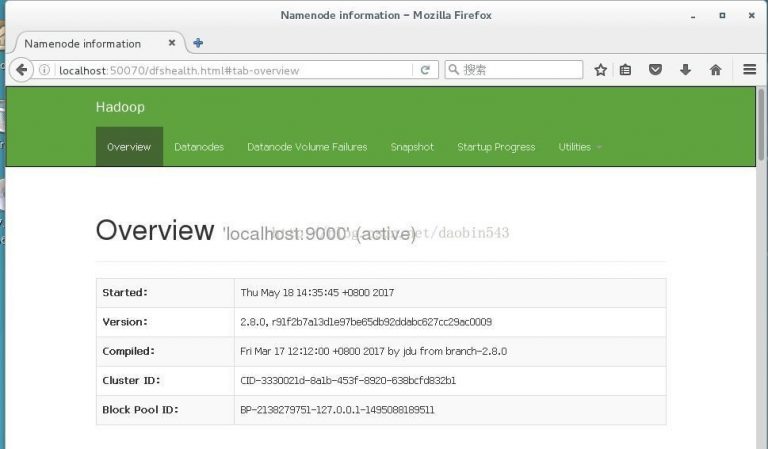

打开浏览器访问http://localhost:50070,验证是否hdfs配置成功

再来启动yarn

1 | sbin/start-yarn.sh |

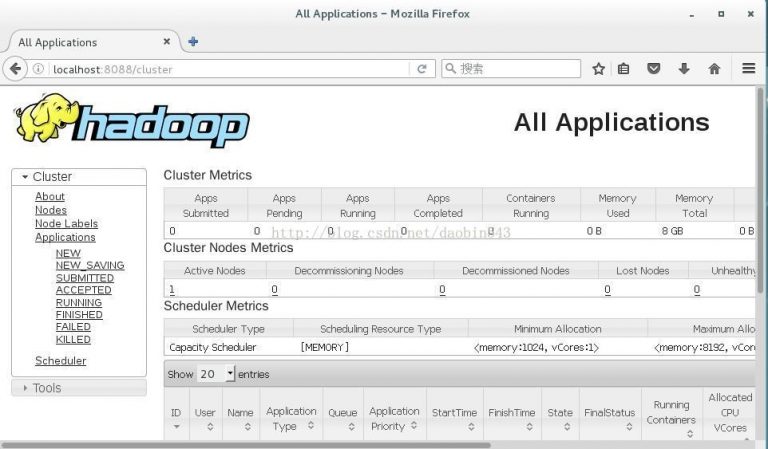

打开浏览器访问http://localhost:8088,验证yarn是否配置成功

注意:由于浏览器存在缓存问题 打开地址可能会失败关闭浏览器 重新打开一两次就好,如果还是失败 检查配置文件是否有误

查看已启动的hadoop进程

jps

注意:如果没有 namenode 或 datanode ,那就是配置不成功

本文由主机测评网发布,不代表主机测评网立场,转载联系作者并注明出处:https://zhujiwo.jb51.net/centos/982.html